Kada upišete upit u ChatGPT ili neki drugi jezični model, lako je steći dojam da komunicirate sa sustavom koji u stvarnom vremenu pretražuje internet kako bi vam ponudio odgovor. Međutim, istina je tehnološki znatno preciznija i iznimno važna za razumijevanje digitalne pismenosti u suvremenom obrazovanju.

Andrej Karpathy, jedan od vodećih svjetskih stručnjaka za umjetnu inteligenciju, nudi mentalni model koji iz temelja mijenja našu percepciju ovih alata. On proces nastanka AI modela uspoređuje sa sustavnim pisanjem i čitanjem udžbenika. Prva faza tog procesa naziva se “pred-treniranje” (Pre-training), a njezin je opseg iznenađujuće “konačan”, što znači da se radi o točno određenoj, mjerljivoj količini podataka, a ne o beskonačnom broju izvora.

Izbor materijala za “digitalni udžbenik”

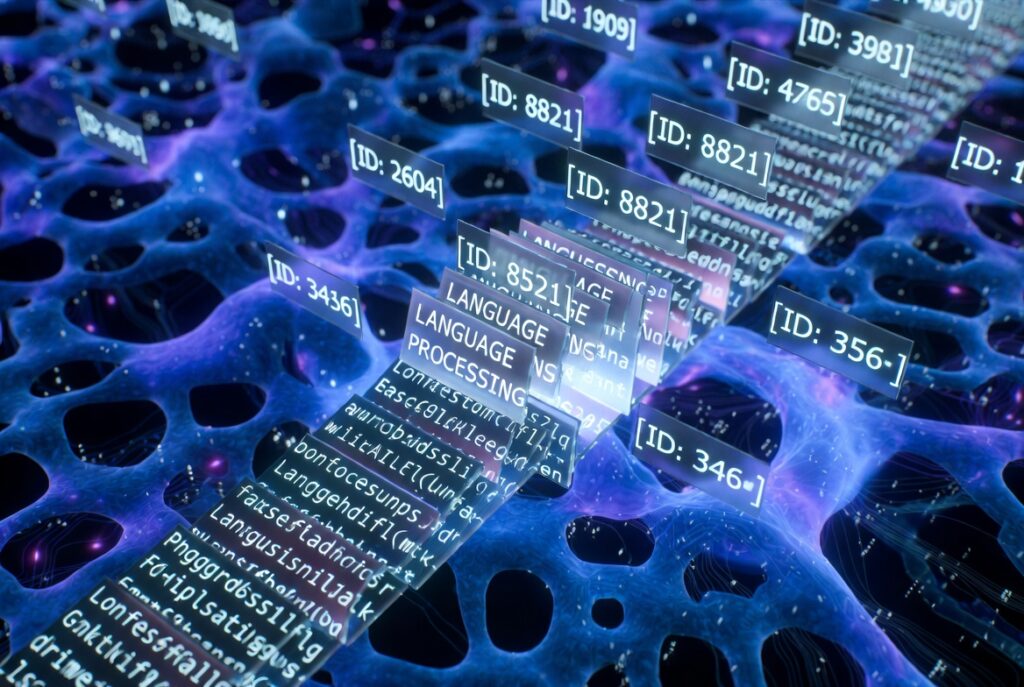

Sve počinje s organizacijama poput Common Crawla, koje godinama arhiviraju milijarde web stranica. Do 2024. godine indeksirano je oko 2,7 milijardi stranica. Iako je riječ o golemom sirovom materijalu, on je u svom izvornom obliku neobrađen. Uz željeni tekst, on sadrži i suvišne elemente izvorne digitalne strukture (poput navigacijskih izbornika, reklamnih blokova i programskih kodova) koji ne pridonose učenju.

Kako bi se to nepregledno mnoštvo informacija uobličilo u sustavno znanje, podaci prolaze kroz proces pažljivog odabira i pročišćavanja:

- URL filtriranje: Uklanjaju se web stranice s “crnih listi” koje sadrže zlonamjerni softver, nepoželjan sadržaj ili govor mržnje.

- Ekstrakcija teksta: Algoritmi uklanjaju vizualni kod (HTML) kako bi izolirali isključivo čisti tekst – rečenice i odlomke.

- Filtriranje jezika: Većina današnjih modela optimizirana je za engleski jezik. Neki skupovi podataka automatski daju prednost stranicama s visokim postotkom teksta na engleskom jeziku, što objašnjava trenutnu superiornost modela u tom jezičnom području.

- Uklanjanje osobnih podataka: Detektiraju se i uklanjaju osjetljive informacije poput adresa ili identifikacijskih brojeva (PII).

Cijelo “znanje” stane u ruksak

Ono što preostane nakon ovog preciznog procesa selekcije je skup podataka vrhunske kvalitete (poput skupa FineWeb). Karpathy ovdje naglašava ključni uvid koji demistificira pojam beskonačnosti:

“Iako je internet golem, radimo isključivo s tekstom koji filtriramo. Na kraju završimo s oko 44 terabajta podataka. To danas gotovo možete smjestiti na jedan veći hard disk koji biste mogli držati u ruci.”

Karpathy koristi moćnu analogiju: AI model je poput visoko komprimirane arhive interneta. Kada je trening završen, model više nema izravan pristup tim podacima, već je znanje “sažeo” u svoje parametre. Baš kao što digitalna fotografija gubi dio izvornih detalja kako bi zauzela manje prostora, tako i AI model ne pamti tekst doslovno, nego pamti statističke veze i uzorke među informacijama.

Što ovo znači za nastavnike i sustav obrazovanja?

Razumijevanje ovog procesa ključno je za ispravno korištenje alata u učionici:

- Model ne “gugla”: Važno je naglasiti da jezični model ne pretražuje internet u potrazi za odgovorima (osim u specifičnim slučajevima kada mu korisnik izravno unese URL ili koristi dodatke za pretraživanje). On stvara odgovor prema naučenim obrascima, umjesto da ga doslovno prepisuje iz izvora. Zato se događa da model ponekad generira uvjerljive, ali netočne činjenice – on ih rekonstruira na temelju statističke vjerojatnosti, a ne provjerom u bazi podataka.

- Znanje je vremenski ograničeno: Budući da je trening proces “čitanja” točno određenog, fiksnog skupa podataka, model ne posjeduje informacije o događajima koji su se zbili nakon završetka te faze, osim ako nije povezan s vanjskim alatima.

Dakle, kada koristimo umjetnu inteligenciju, ne pristupamo sveznajućem stroju, već impresivnom, mjerljivom i pročišćenom sažetku ljudskog znanja pohranjenom u digitalnom obliku.

Izvor: Ovaj članak temelji se na analizi tehničkog predavanja Andreja Karpathyja: Deep Dive into LLMs like ChatGPT i prvi je u nizu članaka u kojima ćemo istražiti dubinsku arhitekturu jezičnih modela. U sljedećem nastavku bavimo se fenomenom tokenizacije – saznajte zašto modeli ponekad griješe u brojanju slova i kako to utječe na njihovo razumijevanje jezika.