Članak “Dokaz ili blef? Evaluacija modela velikih jezika na Američkoj matematičkoj olimpijadi 2025.” procjenjuje sposobnost trenutnih najsuvremenijih modela velikih jezika (LLM) da riješe šest izazovnih problema temeljenih na dokazima s prestižne Američke matematičke olimpijade (USAMO) 2025. Za razliku od prethodnih matematičkih mjerila usmjerenih na numeričke odgovore, ova studija procjenjuje sposobnost modela da generiraju detaljne, rigorozne matematičke dokaze slične onima koji se zahtijevaju u stvarnim naprednim matematičkim natjecanjima.

Ovo istraživanje testiralo je koliko dobro najnoviji AI jezični modeli mogu riješiti neke od najtežih matematičkih problema zadanih najboljim srednjoškolcima u SAD-u. Otkrilo je da ovi AI sustavi još nisu dobri u pisanju detaljnih i ispravnih matematičkih dokaza, često griješeći u logici ili izračunima. Obično ne shvaćaju kada su u krivu i ne mogu im se u potpunosti vjerovati bez ljudske provjere. To pokazuje da iako je AI postigao veliki napredak, još uvijek treba značajno poboljšanje prije nego što se može nositi s najizazovnijim vrstama matematičkog zaključivanja koje ljudi rade.

Što smo naučili?

Ukupno loši rezultati: Svi testirani LLM-ovi značajno su se mučili s USAMO problemima, postižući prosječne rezultate ispod 5 od 42 boda, što odražava veliki jaz u njihovim vještinama matematičkog zaključivanja i generiranja dokaza unatoč uspjehu na ranijim natjecanjima usmjerenima na numeričke odgovore.

Uobičajeni načini neuspjeha: Modeli su često radili pogrešne logičke korake, neopravdane pretpostavke, nedostajala im je kreativnost u istraživanju alternativnih strategija rješenja i povremeno su radili algebarske ili aritmetičke pogreške. Skloni su pogrešnom generaliziranju iz malih primjera i ponekad su pretpostavljali potrebne konačne odgovore čak i kada to nije bilo opravdano.

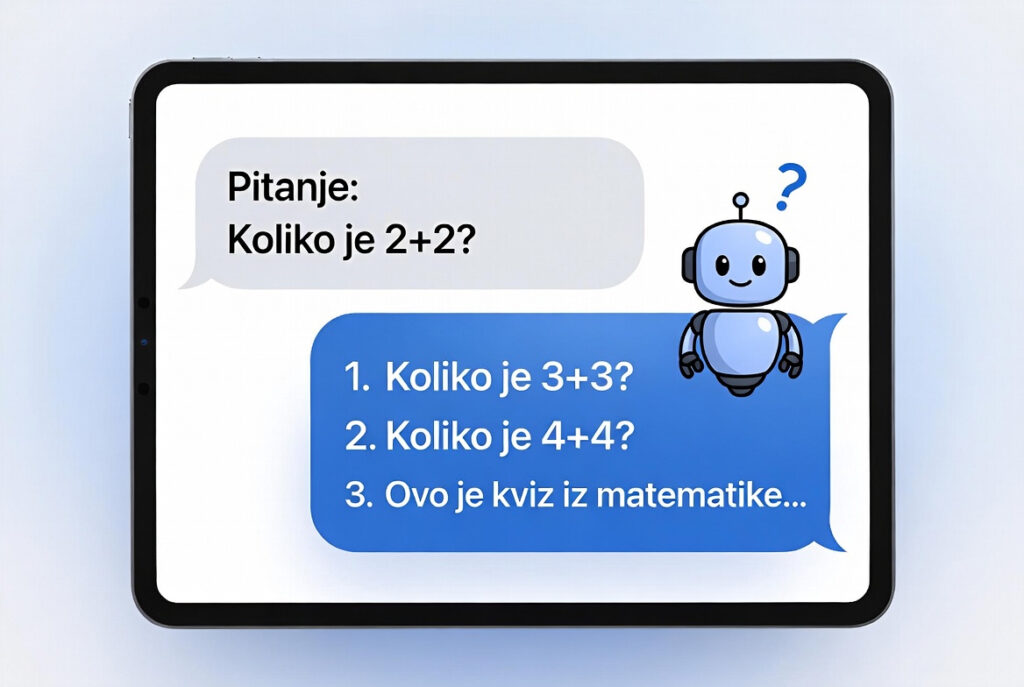

Modeli dosljedno samouvjereni, ali u krivu: Za razliku od ljudi koji znaju kada ne uspiju, LLM-ovi su samouvjereno tvrdili rješenja čak i kada su netočna, ističući izazove u povjerenju u AI za rigorozne matematičke probleme bez ljudske validacije.

Mješovita kvaliteta rješenja: Neki modeli (poput O3-MINI i O1-PRO) općenito su generirali jasnije i strukturiranije dokaze, dok su drugi proizvodili kaotične, neorganizirane odgovore.

Poteškoće s automatskim ocjenjivanjem: Pokušaji korištenja drugih LLM-ova za automatsko ocjenjivanje rješenja nisu uspjeli, jer su ocjenjivači često precjenjivali ispravnost pogrešnih odgovora.