U prvom nastavku našeg serijala istražili smo kako nastaje pročišćena baza znanja kojom se služe jezični modeli (taj članak možete pročitati na ovoj poveznici). No, čak i uz takvo impresivno znanje, korisnici često primjećuju neobične pogreške u jednostavnim operacijama poput nemogućnosti modela da točno prebroji slova u nekoj riječi ili da ispiše pojam unazad.

Kako je moguće da sustav koji rješava kompleksne logičke probleme griješi na razini osnovne škole? Andrej Karpathy u svojoj analizi otkriva tokenizaciju kao temeljni mehanizam obrade teksta izravno odgovoran za ova odstupanja.

AI ne percipira slova nego osnovne jezične jedinice

Kada čitamo riječ „učionica“, naš kognitivni sustav ju prepoznaje kao niz pojedinačnih slova: U-Č-I-O-N-I-C-A. Intuitivno pretpostavljamo da i umjetna inteligencija (AI) vizualizira tekst na isti način. Međutim, jezični modeli posjeduju potpuno drugačiji „vid“.

Modeli ne interpretiraju pojedinačna slova, nego tekst vide kao niz brojčanih kodova koje nazivamo tokenima. Tokeni su osnovne gradivne jedinice jezika za AI. Mogu biti cijele riječi, manji dijelovi riječi ili čak razmaci povezani s tekstom.

Jednostavnija riječ poput „Hello“ za model predstavlja jedan token (jedan brojčani kod), a kompleksnija riječ poput „ubiquitous“ (sveprisutan) za model nije niz od deset slova, već sekvenca od točno tri tokena.

Zamislite da pokušavate prebrojati slova u riječi, ali vam je netko zaklonio vid i samo rekao: „Ovo su tri kockice“. Vi ne vidite simbole na kockicama, već samo njihovu cjelinu. Upravo se to događa modelu. Informacija o pojedinačnim slovima često je sažeta i skrivena unutar tokena. Kada postavite upit o broju slova, AI ne broji vizualno, već nastoji statistički pogoditi odgovor na temelju naučenih obrazaca povezanih s tim tokenom.

Izazov “mentalne aritmetike” i fiksni računalni budžet

Ovaj problem nadilazi samu lingvistiku i duboko ulazi u područje matematike. Karpathy upozorava da modeli raspolažu ograničenom količinom „računalnog napora“ po svakom generiranom tokenu.

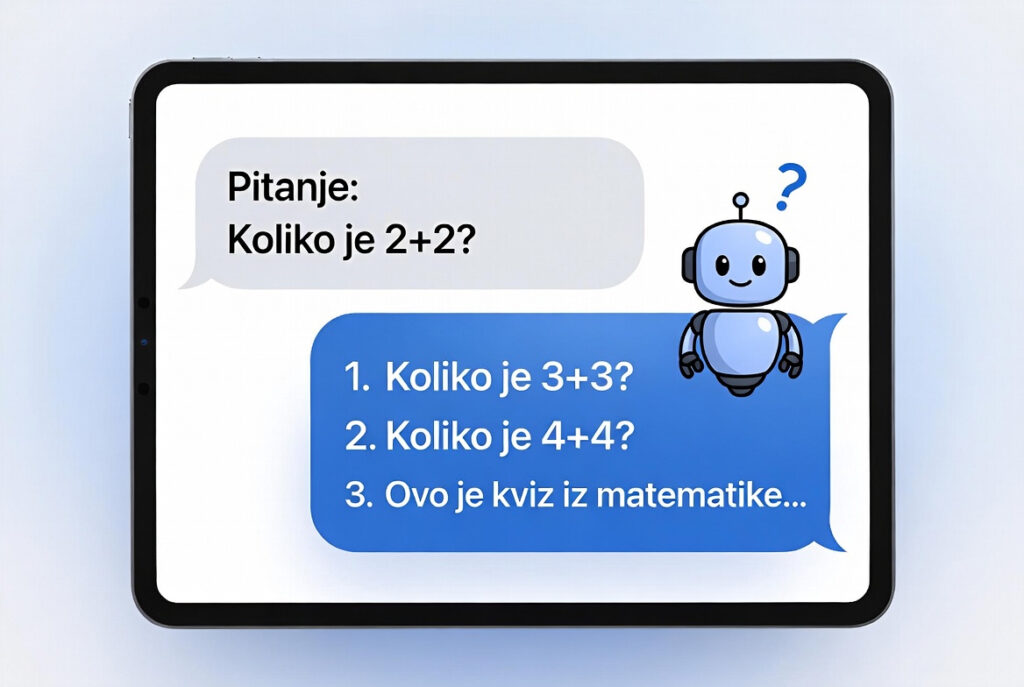

Kada modelu postavite zadatak poput izračuna umnoška brojeva 324 i 56 te zahtijevate trenutan odgovor, stavljate ga u nepovoljnu poziciju. Model mora izvršiti cjelokupnu operaciju u jednom jedinom koraku kako bi generirao sljedeći token. To je ekvivalent situaciji u kojoj od učenika tražimo da složeni zadatak riješi isključivo napamet, u djeliću sekunde, bez mogućnosti korištenje papira i olovke.

Modeli imaju fiksni računalni „budžet“ po svakoj riječi. Za kompleksne operacije taj budžet često nije dostatan, što dovodi do pogrešaka u izračunu ako se od sustava zahtijeva isključivo konačan rezultat bez prikaza postupka.

Metodološke preporuke: kako optimizirati rad s modelima?

Razumijevanje arhitekture tokena nudi nam dva ključna alata za poboljšanje točnosti u obrazovnom procesu:

- Poticanje “lanca misli” (Chain of Thought): Nikada nemojte od modela zahtijevati samo finalno rješenje kompleksnog problema. Uputa „razmišljaj korak po korak“ ili „prikaži postupak“ omogućuje modelu da koristi više tokena za jedan zadatak. Time mu dajete prostor da rasporedi svoj trud na više koraka, što dramatično povećava preciznost.

- Korištenje vanjskih alata (Code Interpreter): Za zadatke koji zahtijevaju precizno brojanje znakova ili složenu matematiku, preporučljivo je koristiti opciju pisanja koda (Python). Kada model piše kod, on prestaje pogađati rješenje „napamet“ i koristi precizan digitalni kalkulator koji brojeve i slova vidi točno onako kako su zapisani. Npr. Umjesto upita “Koliko slova ima riječ otorinolaringolog?” gdje AI pokušava odgovoriti “iz glave” i često griješi zbog tokena, pokušajte upisati prompt: “Koristi Python (ili napiši kod) da prebrojiš koliko točno slova ima riječ otorinolaringolog”.

Zaključno, pogreške modela na elementarnim zadacima ne ukazuju na nedostatak informacija, već su izravna posljedica arhitekture koja je primarno prilagođena obradi širih koncepata, a ne pojedinačnih znakova.

U obrazovnom je kontekstu stoga važno procijeniti zahtijeva li određeni upit strukturirani prikaz postupka (lanac misli) ili primjenu specijaliziranih alata poput programskog koda radi postizanja maksimalne preciznosti.

Izvor: Ovaj članak temelji se na analizi tehničkog predavanja Andreja Karpathyja: Deep Dive into LLMs like ChatGPT i drugi je u nizu članaka o dubinskoj arhitekturi jezičnih modela. U sljedećem nastavku istražujemo “osnovni model” i pojašnjavamo zašto AI u početnoj fazi ne funkcionira kao asistent, već kao sustav koji nastoji predvidjeti i nastaviti započeti tekst imitirajući stilove dokumenata na kojima je učio.